L’analyse de la variance (ANOVA) peut déterminer si les moyennes de trois groupes ou plus sont différentes. ANOVA utilise des tests F pour tester statistiquement l’égalité des moyennes. Dans cet article, nous allons vous montrer comment ANOVA et les tests F fonctionnent en utilisant un exemple d’une ANOVA à un facteur contrôlé.

Mais attendez une minute... avez-vous déjà cessé de vous demander pourquoi vous utilisez une analyse de Variance pour déterminer si les moyennes sont différentes ? Analysons comment les écart-types fournissent des informations sur les moyennes.

Comme dans un article précédent sur la compréhension des tests t, nous allons nous concentrer sur les concepts et les graphiques plutôt que les équations, pour expliquer les tests F de l’ANOVA.

Qu’est-ce que les statistiques F et le test F?

Les tests F sont nommés d’après sa statistique, F du test, qui a été nommé en l’honneur de Sir Ronald Fisher. La statistique F est simplement un ratio de deux écart-types. Les écart-types sont une mesure de dispersion, ou dans quelle mesure les données sont dispersées de la moyenne. De plus grandes valeurs représentent une plus grande dispersion.

La variance est le carré de l’écart type. Pour nous, les humains, les écarts-types sont plus faciles à comprendre que les variances parce qu’ils sont dans les mêmes unités que les données plutôt que les unités carrées. Cependant, de nombreuses analyses utilisent en fait des écarts dans les calculs.

Les statistiques F sont basées sur le rapport des carrés moyennes. Le terme "carrés moyen" peut sembler déroutant, mais c’est simplement une estimation de la variance de la population qui explique le degrés de liberté (DL) pour calculer cette estimation.

En dépit d’être un rapport de variances, vous pouvez utiliser des tests F dans une grande variété de situations. Sans surprise, le test F peut évaluer l’égalité des écart-types. Toutefois, en modifiant les écart-types qui sont inclus dans le rapport, le test de F devient un test très flexible. Par exemple, vous pouvez utiliser des statistiques F et des tests F pour tester la pertinence globale d’un modèle de régression, pour comparer la qualité des ajustements des différents modèles, et pour tester des termes de régression spécifiques et tester l’égalité des moyennes.

Utilisation du test F dans une ANOVA à un facteur contrôlé

Pour utiliser le test F pour déterminer si les moyennes de groupe sont égales, il s’agit simplement d’inclure les écart-types corrects dans le rapport. Dans l’ANOVA à un facteur contrôlé, la statistique F est le rapport suivant :

F - Variation entre les moyennes d’échantillonnage / l’intérieur des échantillons

La meilleure façon de comprendre ce rapport est de parcourir un exemple d'ANOVA à un facteur contrôlé.

Nous allons analyser quatre échantillons de plastique pour déterminer s’ils ont des résistances moyennes différentes. Vous pouvez télécharger l’exemple de données si vous voulez suivre l'exercice.

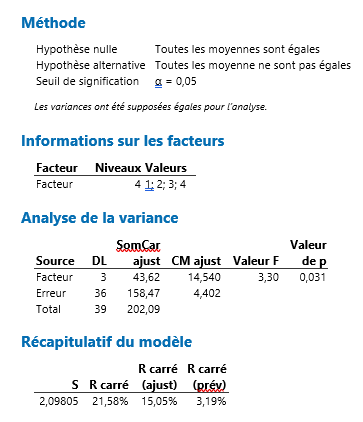

Dans Minitab, choisissez Stat - ANOVA - à un facteur .. Dans la boîte de dialogue, choisissez « Force » comme réponse, et « Échantillon » comme facteur. Appuyez sur OK, et la fenêtre de session de Minitab affiche la sortie suivante :

Numérateur : Variation entre les moyennes des échantillons

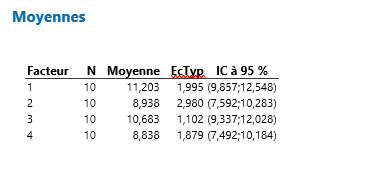

L'ANOVA à un facteur contrôlé a calculé une moyenne pour chacun des quatre échantillons de plastique. Les moyennes des groupes sont les moyennes: 12,171 ; 8,61 ; 10,643 ;9,621. Ces moyennes de groupe sont réparties autour de la moyenne globale pour les 40 observations, qui est de 10,261. Si les moyennes du groupe sont regroupées près de la moyenne globale, leur variance est faible. Toutefois, si les moyennes du groupe sont répartis de manière plus éloignée de la moyenne globale, leur écart variance est plus élevée.

De toute évidence, si nous voulons montrer que les moyennes sont différentes, il est utile que les moyennes soient plus éloignées les unes des autres. En d’autres termes, nous voulons une plus grande variabilité entre les moyennes.

Imaginez que nous effectuons deux ANOVAs à un facteur contrôlé différents où chaque analyse comporte quatre groupes. Le graphique ci-dessous montre la distribution des moyennes. Chaque point représente la moyenne d’un groupe entier. Plus les points sont écartés, plus la valeur de la variabilité du numérateur de la statistique F est élevée.

Quelle valeur utilisons-nous pour mesurer la variance entre les moyennes de l’échantillon pour l’exemple de résistance en plastique ? Dans la sortie ANOVA à un facteur contrôlé, nous utiliserons le carré moyen ajusté (Adj MS) pour Facteur, qui est de 23,10. N’essayez pas d’interpréter ce nombre parce qu’il n’aura pas de sens. C’est la somme des écarts au carré divisés par le degré de liberté pour facteur. Il suffit de garder à l’esprit que plus les moyennes des groupes sont écartées les unes des autres, plus ce nombre devient important.

Dénominateur : Variation à l’intérieur des échantillons

Nous avons également besoin d’une estimation de la variabilité au sein de chaque échantillon. Pour calculer cette variance, nous devons calculer à quelle distance chaque observation est de sa moyenne de groupe pour les 40 observations. Techniquement, c’est la somme des écarts au carré de chaque observation de la moyenne de son groupe divisé par le degré de liberté de l’erreur.

Si les observations pour chaque groupe sont proches de la moyenne du groupe, la variance à l’intérieur des échantillons est faible. Toutefois, si les observations pour chaque groupe sont plus éloignées de la moyenne du groupe, la variance à l’intérieur des échantillons est plus élevée.

Dans le graphique, le panneau de gauche montre une faible variation dans les échantillons tandis que le panneau de droite montre une variation élevée. Plus les observations sont éloignées de leur moyenne de groupe, plus la valeur dans le dénominateur de la statistique F est élevée.

Si nous espérons montrer que les moyennes sont différentes, il faut obtenir une variance faible au sein du groupe. Vous pouvez considérer la variance à l’intérieur du groupe comme le bruit de fond qui peut masquer une différence entre les moyennes.

Pour cet exemple ANOVA à un facteur contrôlé, la valeur que nous allons utiliser pour la variance à l’intérieur des échantillons est la CM ajusté de l’Erreur, qui est de 4.402. Il est considéré comme «erreur» parce que c’est la variabilité qui n’est pas expliquée par le facteur.

Prêt(e) pour une démonstration du logiciel d'analyse de données Minitab ? Ecrivez-nous >

La Statistique F : Variation entre les moyennes d’échantillon / Variation à l’intérieur des échantillons

La statistique F est la statistique du test pour les tests F. En général, une statistique F est un rapport de deux quantités qui devraient être à peu près égales selon l’hypothèse nulle, qui produit une statistique F d’environ 1.

La statistique F intègre les deux mesures de variabilité mentionnées ci-dessus. Jetons un coup d’oeil à la façon dont ces mesures peuvent travailler ensemble pour produire des valeurs F faibles et élevées. Regardez les graphiques ci-dessous et comparez la largeur de la variabilité des moyennes des groupes à la largeur de la variabilité à l’intérieur de chaque groupe.

Le graphique démontre une faible valeur F et affiche un cas où les moyennes du groupe sont proches les uns des autres (faible variabilité) par rapport à la variabilité à l’intérieur de chaque groupe. Le graphique de valeur F élevé montre un cas où la variabilité des moyennes des groupes est grande par rapport à la variabilité au sein du de chaque groupe. Afin de rejeter l’hypothèse nulle que les moyennes des groupes sont égales, nous avons besoin d’obtenir une valeur de F élevée.

Pour notre exemple de résistance en plastique, nous utiliserons le CM ajust du Facteur pour le numérateur (14,540) et le carré moyen ajusté de l’Erreur pour le dénominateur (4,402) ce qui nous donne une valeur de F de 3,30.

Notre valeur F est-elle assez élevée ? Une seule valeur F est difficile à interpréter par elle-même. Nous devons placer notre valeur F dans un contexte plus large avant de pouvoir l’interpréter. Pour ce faire, nous utiliserons la distribution F pour calculer les probabilités.

Distributions F et tests d’hypothèses

Pour l’ANOVA à un facteur contrôlé, le rapport entre la variabilité inter-groupes et la variabilité à l’intérieur des groupes suit une distribution F lorsque l’hypothèse nulle est vraie.

Lorsque vous effectuez une ANOVA à un facteur contrôlé pour une seule étude, vous obtenez une seule valeur F. Cependant, si nous tirions plusieurs échantillons aléatoires de la même taille de la même population et exécutions la même ANOVA à un facteur contrôlé, nous obtiendrions de nombreuses valeurs de F et nous pourrions tracer une distribution de chacun d’elles. Ce type de distribution est connu sous le nom de distribution d’échantillonnage.

Parce que la distribution F suppose que l’hypothèse nulle est vraie, nous pouvons placer la valeur F de notre étude dans la distribution F pour déterminer dans quelle mesure nos résultats sont cohérents avec l’hypothèse nulle et pour calculer les probabilités.

La probabilité que nous voulons calculer est la probabilité d’observer une statistique F qui est au moins aussi élevée que la valeur que notre étude a obtenue. Cette probabilité nous permet de déterminer à quel point notre valeur F est très probable ou rare en supposant que l’hypothèse nulle est vraie. Si la probabilité est assez faible, nous pouvons conclure que nos données sont incompatibles avec l’hypothèse nulle. Les preuves issues des données de l’échantillon sont suffisamment solides pour rejeter l’hypothèse nulle pour l’ensemble de la population.

Cette probabilité que nous calculons est également connue sous le nom de valeur de p !

Pour tracer la distribution F pour notre exemple de résistance en plastique, je vais utiliser les diagrammes de loi de probabilité de Minitab. Afin de tracer la distribution F qui convient à notre plan d’expérience et la taille de l’échantillon spécifique, nous aurons besoin de préciser le nombre correct de DL. En regardant notre sortie ANOVA à un facteur contrôlé, nous pouvons voir que nous avons 3 DL pour le numérateur et 36 DL pour le dénominateur.

Le graphique affiche la distribution des valeurs de F que nous obtiendrions si l’hypothèse nulle est vraie et nous répétons notre étude plusieurs fois. La zone ombragée représente la probabilité d’observer une valeur de F qui est au moins aussi grande que la valeur F que notre étude a obtenue. Les valeurs F se situent dans cette région ombragée pour environ 3,1 % du temps dans le cas où l’hypothèse nulle est vraie. Cette probabilité est suffisamment faible pour rejeter l’hypothèse nulle avec un niveau de signifiance standard de 0,05. Nous pouvons conclure que toutes les moyennes des groupes ne sont pas égales.

Apprenez à interpréter correctement la valeur p.

Évaluer les moyennes par l’analyse de la variation

L'ANOVA utilise le test F pour déterminer si la variabilité entre les moyens de groupe est plus grande que la variabilité des observations à l’intérieur des groupes. Si ce rapport est suffisamment élevé, vous pouvez conclure que toutes les moyennes ne sont pas égales.

Cela nous ramène à la raison pour laquelle nous analysons les variations pour porter des jugements sur les moyennes. Pensez à la question : « Les moyennes des groupes, sont-elles différentes ? » Vous posez implicitement des questions sur la variabilité des moyennes. Après tout, si les moyennes des groupes ne se varient pas, ou ne se varient pas par plus par rapport à ce que nous nous puissions nous attendre obtenir par hasard, vous ne pouvez pas dire que les moyennes soient différentes.

Et c’est pourquoi vous utilisez l’analyse de la variance pour tester les moyennes.

Découvrez et essayez gratuitement la version d'essai du logiciel d'analyse de données Minitab >