Cet article vous explique la valeur ajoutée des statistiques modernes combinée à la puissance informatique. La société Minitab a fait l'acquisition de la société Salford Systems en 2017, spécialisée dans les solutions logicielles permettant l'exploration des données et l'analyse prédictive. Les modèles déposés de Salford Predictive Modeler ont été développés, et sont sans cesse améliorés, avec la collaboration directe des créateurs du machine learning et du datamining Leo Breitman de l’Université de Berkeley et Jerome H. Friedman de l’Université de Stanford, aux Etats-Unis. Salford Systems déploie un programme soutenu de recherche et développement, en lien étroit avec les meilleures universités américaines.

Les données déjà stockées dans vos serveurs sont une mine d’or. Les banques, les assurances, les sociétés de télécommunication peuvent tirer parti des données qu'elles possèdent pour améliorer leurs opérations, mieux comprendre leurs clients et à bien d'autres fins. Avec Industrie 4.0 et l'Internet des objets (IoT), de plus en plus de données seront collectées en temps quasi réel, provenant de capteurs installés sur les produits, d'équipements sur les lignes de production, des enregistrements réalisés lors de l'acte d'achat, etc. Etre en mesure de collecter, rassembler et analyser ces informations devient de plus en plus critique pour trouver des leviers d'amélioration, de performance et de croissance. C'est une belle opportunité à saisir et un véritable défi à relever.

Un nouveau défi

De même que les analyses ne sont pas les mêmes pour les grandes et les petites séries, les analyses des grandes quantités de données provenant de ces systèmes modernes sont spécifiques, les méthodes employées diffèrent de celles utilisées pour des jeux de données plus petits. Ces masses de données peuvent contenir un grand nombre de prédicteurs, un grand nombre de lignes ou les deux. Il est également fréquent que des données d'observation comme celles-ci soient plus complexes que ce que vous pourriez trouver avec des données obtenues à partir d'expériences soigneusement conçues.

Un grand nombre de prédicteurs

Les tests de modélisation statistique s'appuient sur la valeur de P pour détecter les effets significatifs. Ainsi, un prédicteur avec une valeur de p inférieure à 0,05 est généralement considéré comme statistiquement significatif. Toutefois, nous devons garder en tête que cette référence fixée à 0,05 signifie que nous acceptons une marge d'erreur de 5%, c'est-à-dire qu'un prédicteur sur vingt sera considéré comme significatif aléatoirement. Avec un nombre élevé de prédicteurs, une approche fondée sur l'étude des valeurs de P peut amener à modéliser du bruit créé aléatoirement.

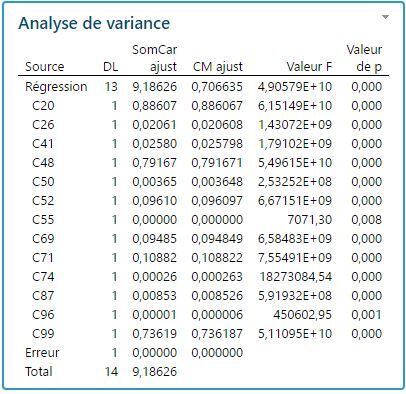

Pour illustrer ce point, j'ai simulé aléatoirement 100 colonnes normalement distribuées avec 15 observations chacune. Une régression pas à pas montre que pas moins de 13 colonnes sur 99 variables ont un effet statistiquement significatif sur la dernière colonne (valeurs P très proches de 0) et que la valeur R carré est extrêmement élevée (100%). Évidemment, tous ces effets sont faux, exclusivement causés par des fluctuations aléatoires (voir les résultats ci-dessous).

Un grand nombre d'observations : puissance ou implication pratique

De très grandes tailles d'échantillons améliorent la puissance et la capacité à détecter des termes statistiquement significatifs même lorsque leurs effets sont faibles et très faibles. Toutefois, de tels effets statistiquement significatifs n'ont pas nécessairement un effet notable en pratique, sur le terrain. Avec des ensembles volumineux de données, la valeur de P peut devenir trop sensible à des petits effets réels, conduisant à un modèle final très complexe. Il comprendra la plupart des prédicteurs initialement listés comme facteurs potentiels, ne nous permettant pas d’identifier les plus influents.

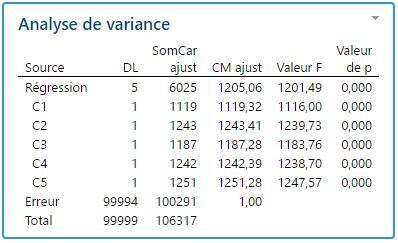

Pour illustrer cela, j'ai simulé 6 colonnes avec 100 000 observations chacune, j'ai entré un modèle tel que les 5 colonnes d'entrée aient un effet minime sur la dernière colonne (impact réel mais très faible). Le R carré est, bien entendu, extrêmement faible (proche de 0%) mais les valeurs P indiquent que les effets sont très significatifs d'un point de vue statistique (voir les résultats ci-dessous).

Même si ces termes peuvent être statistiquement significatifs, la plupart d'entre eux auraient en réalité peu de significativité en pratique, sur le terrain.

Une complexité due aux effets non linéaires, aux valeurs aberrantes et aux valeurs manquantes

Avec une plage de valeurs plus grande et sur une période de temps prolongé, les variables sont susceptibles de suivre des modèles non linéaires. Des ensembles de données conséquents sont susceptibles de comprendre des valeurs manquantes et des valeurs aberrantes, elles affecteront l'efficacité des tests de modélisation statistique. Ainsi, en raison d'une seule valeur manquante par exemple, la ligne complète d'observations pourrait ne pas être prise en compte dans le modèle.

Prenons plusieurs exemples concrets. Les volumes de données à analyser seront conséquents pour une banque si elle veut identifier les transactions frauduleuses, pour une entreprise industrielle si elle veut isoler les détracteurs de rendement ou pour une entreprise qui suit les enregistrements des paramètres de ses équipements pour éviter toute panne et optimiser la maintenance. Le nombre de prédicteurs est susceptible d'être élevé, avec beaucoup d’observations, de nombreux effets non linéaires complexes, des valeurs manquantes et des valeurs aberrantes.

Analyse exploratoire « Datamining » et analyse prédictive

De puissantes solutions informatiques d'apprentissage machine automatique appelées « Machine Learning » permettent de fournir des modèles prédictifs robustes. Ainsi, des méthodes tells que les arbres de classification et de régression CART, le Gradient Boosting Treenet et la régression multivariée par spline adaptative (en anglais MARS pour « Multivariate adaptive regression splines ») seront très utiles aux personnes qui veulent analyser des jeux de données conséquents.

Bien sûr, les jours des jeux de données de petite ou moyenne taille sont loin d'être comptés. Des tests statistiques tels que les plans d'expériences et la modélisation statistique resteront très utiles aux ingénieurs méthodes et procédés, aux services R & D, aux ingénieurs Qualité, pour optimiser les produits, les services ou les processus. Black Belts et Master Black Belts continueront à déployer des méthodes d'analyse de données préconisées par l’approche Six Sigma pour l'analyse des causes premières, l'amélioration de la qualité et de la performance à tous les niveaux de l'entreprise, en utilisant les valeurs de P pour identifier les prédicteurs statistiquement significatifs. La principale force des techniques de modélisation statistique réside dans les équations faciles à interpréter qu’elles fournissent, utiles pour simuler des changements, comprendre le fonctionnement du système et évaluer l'impact de chaque facteur et de chaque interaction, statistiquement significatifs.

Conclusion

Alors que les organisations souhaitent extraire des informations pertinentes d'une quantité toujours croissante de données, il devient de plus en plus important de choisir les bons outils pour pouvoir analyser des données de tailles et de complexités variables.

Les outils de Machine Learning tels que Classification and Regression Tree, Random Forests, TreeNet Gradient Boosting et Multivariate Adaptive Regression Splines sont pertinents parce qu'ils sont moins sensibles aux limites listées ci-dessus. Ces techniques d'arbres de décision ne sont pas basées sur le seuil de significativité des valeurs de p, mais sur des règles telles que SI, OU, ET qui compensent les valeurs manquantes et neutralisent les valeurs aberrantes. Les techniques de modélisation plus classiques telles que la régression continueront d'être des outils de choix lorsque les hypothèses du modèle sont validées et lorsque l'objectif est de trouver une équation facilement interprétable.

Les statistiques et l'apprentissage automatique jouent un rôle essentiel dans la recherche de renseignements exploitables, l'utilisation conjointe de ces deux méthodes axées sur les données permettra aux organisations de prendre de meilleures décisions et d'acquérir un avantage concurrentiel.

A celles et ceux qui souhaitent interpréter des volumes importants de données complexes, la société Minitab offre une solution robuste et performante - Salford Predictive Modeler - pour l'exploration de données et l'analyse prédictive comprenant les techniques CART et MARS décrites dans cet article ; et d'autres méthodes de Datamining puissantes. Nous vous proposons de visionner en ligne l'enregistrement vidéo " Machine Learning: a new step in manufacturing performance" en anglais, pour découvrir comment la plateforme de modélisation prédictive Salford Predictive Modeler de Minitab peut vous aider à relever le défi de l’analyse de grands jeux complexes de données.

WEBINAIRE A LA DEMANDE

Les arbres de régression et de classification CART® ont révolutionné le domaine de l'analyse avancée, ouvrant sur une nouvelle ère du Machine Learning. Ils sont aujourd'hui l'un des outils de prévision les plus populaires et les plus utiles. Découvrez cet outil analytique dans notre webinaire en ligne >