MiniSi vous êtes spécialiste du marketing, vous savez qu’envoyer simplement des e-mails promotionnels en espérant qu’ils soient efficaces n’est pas la meilleure solution. Idéalement, vous devez prendre le temps d’étudier les performances de vos e-mails et découvrir les mesures à appliquer pour les améliorer.

Vous pourriez envoyer deux versions d’un e-mail marketing à un échantillon de vos lecteurs et comparer les mesures de réussite avant d’envoyer la meilleure version à l’ensemble de votre audience. Vous pourrez ainsi identifier la meilleure version en fonction de ses indicateurs de réussite via le taux d’ouverture et/ou le taux de clics.

Le taux d’ouverture correspond au pourcentage de personnes qui ont ouvert votre e-mail parmi celles qui l’ont reçu. Le taux de clics correspond au pourcentage de contacts ayant reçu votre e-mail et ayant cliqué sur au moins un lien dans le message, démontrant ainsi plus d’intérêt que le simple fait d’ouvrir l’e-mail.

Nous allons partager avec vous un cas d’utilisation qui a fonctionné pour notre équipe marketing chez Minitab. Nous avons effectué un test A/B pour comparer deux versions d’un e-mail et avons examiné les taux de clics comme mesures de réussite.

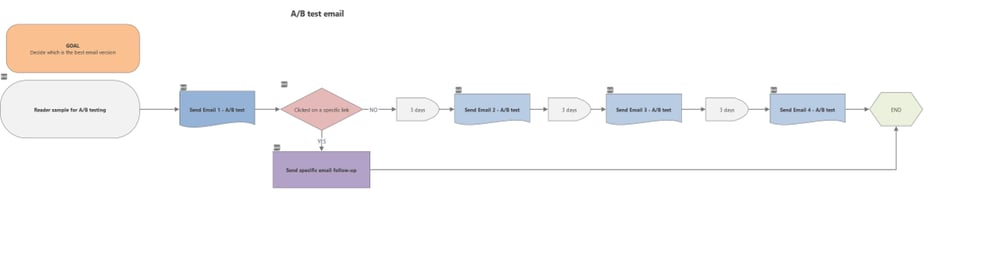

L’équipe a documenté le test avec une cartographie de procédé pour décrire les étapes

Pour en savoir plus sur les cartographies de procédé à l’aide du logiciel Minitab Workspace®, consultez notre article Introduction aux cartographies de procédé >

Avant d’exécuter le test, nous nous sommes posé les questions suivantes :

- Comment pouvons-nous déterminer les effectifs d’échantillon nécessaires pour tester deux versions d’un e-mail, afin que les mesures de réussite soient estimées avec suffisamment de précision ?

- Comment pouvons-nous comparer deux versions d’un e-mail afin de détecter une différence particulière en termes de réussite ?

Les deux questions nécessitent une référence en termes de mesures de réussite. Nous avons donc utilisé d’anciennes données pour faire des estimations. Nous voulions connaître les indicateurs de réussite de référence pour un e-mail marketing similaire destiné au même public cible. Dans cet exemple, notre référence est un même e-mail envoyé à un même public où 340 lecteurs sur 100 000 ont cliqué sur un ou plusieurs liens présents dans l’e-mail. Le taux de clic de référence est de 0,34 %.

METTEZ CELA EN PRATIQUE :

- 1ère façon de calculer l’effectif des échantillons pour comparer l’efficacité de deux versions d’un e-mail :

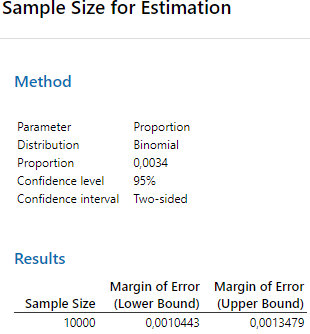

Vous pouvez calculer le nombre de lecteurs à échantillonner à l’aide du test Effectif de l’échantillon pour l’estimation dans Minitab® Statistical Software pour estimer votre taux de clics avec une certaine marge d’erreur.

Prenons par exemple un échantillon de 10 000 contacts d’une population au moins 10 fois plus importante, soit au moins 100 000 lecteurs au total. Si le taux de clics attendu est notre référence de 0,34 %, la limite inférieure au niveau de 95 % serait de 0,21 % et la limite supérieure de 0,47 %.

Utilisez Stat>Puissance et effectif de l’échantillon>Effectif de l’échantillon pour l’estimation dans Minitab Statistical Software®. L’intervalle de confiance à 95 % serait compris entre 0,24 % et 0,47 % pour le taux de clics.

Comme l’effectif de l’échantillon est faible par rapport à l’effectif de la population, les distributions binomiales ou hypergéométriques pour modéliser les données échantillonnées fourniraient des résultats similaires. Il vous appartient de décider si cette marge d’erreur pour les taux de clics est acceptable et si elle estimera cette mesure de réussite avec une précision suffisante.

- 2ème façon de calculer l’effectif des échantillons pour comparer la réussite de deux versions d’un e-mail :

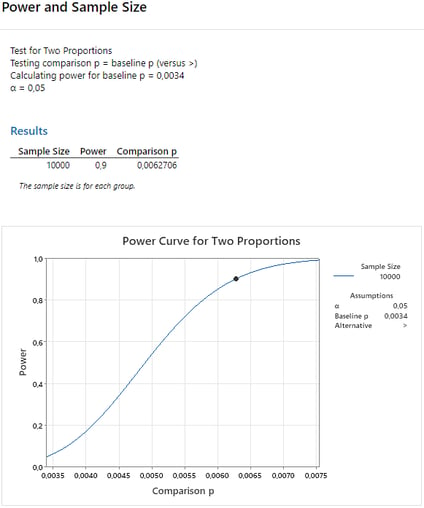

À l’aide du test à 2 proportions, disponible dans le menu Stat>Statistiques élémentaires>Test à 2 proportions de Minitab Statistical Software, vous pouvez déterminer l’effectif d’échantillon nécessaire pour détecter une certaine différence entre les taux de clics des deux versions de l’e-mail avec une probabilité ou une puissance requise.

Le taux de clics de référence pour votre première campagne e-mailing est de 0,34 %. La variation que vous pourriez détecter dans le taux de clics serait de 0,34 % à 0,63 % dans 90 % des cas si vous choisissez un échantillon de 10 000 contacts pour chaque version d’e-mail.

Utilisez Stat>Puissance et effectif de l’échantillon>Test à 2 proportions pour déterminer l’effectif de l’échantillon

Si vous souhaitez détecter une différence plus faible entre les taux de clics, vous pouvez augmenter l’effectif de l’échantillon pour voir son impact sur la sensibilité du test.

Prêt à déterminer l’effectif de l’échantillon pour vos propres comparaisons ? Démarrer votre version d’essai de Minitab Statistical Software >

Quel test statistique peut aider à comparer l’efficacité de chacune des deux versions d’e-mail envoyées ?

Maintenant que le test est exécuté, nous aimerions comparer les résultats pour sélectionner la meilleure version de l’e-mail.

Nombre d’e-mails envoyés, d’ouvertures et de clics pour chacune des deux versions de l’e-mail

Bien que les pourcentages semblent plus élevés pour la version B dans ce tableau descriptif, il est important d’utiliser un test statistique pour vérifier si la différence est significative pour la mesure de réussite que l’équipe examine dans cet exemple, à savoir le taux de clics.

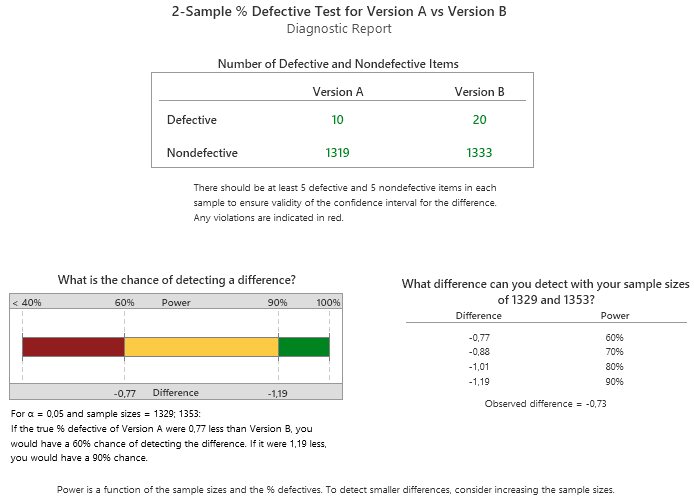

Le test statistique est appelé Test de pourcentage de défectueux à 2 échantillons et est accessible dans le menu Assistant de Minitab Statistical Software. En règle générale, ce test est utilisé pour démontrer la différence dans les taux de défauts de deux populations par échantillonnage. Dans cet exemple, l’événement de référence n’est pas une unité défectueuse, mais un clic. Ainsi, un taux de défauts élevé signifie un taux de clics élevé.

Utilisez Assistant>Tests d’hypothèse>Comparer deux échantillons l’un avec l’autre>Test de pourcentage de défectueux à 2 échantillons pour comparer les taux de clics des deux versions de l’e-mail : la version A et la version B

Les résultats fournissent des lignes directrices sur la façon d’interpréter les données.

Les résultats statistiques révèlent que les données fournissent des preuves suffisantes au niveau de 10 % pour conclure que le pourcentage de défectueux, ici le pourcentage de clics, de la version A est significativement inférieur à celui de la version B.

La raison en est simple : chaque version de l’e-mail n’a pas été envoyée aux échantillons recommandés de 10 000 lecteurs. Comme dans de nombreuses expériences réelles, le test n’a pas pu être exécuté dans les conditions recommandées.

Les effectifs d’échantillon utilisés ne permettent de détecter qu’une réelle augmentation du taux de clics d’environ 1 % par rapport aux versions A à B de l’e-mail lorsque cette différence existe.

L’équipe peut maintenant décider soit de sélectionner des échantillons supplémentaires pour augmenter la puissance du test, soit de choisir une version de l’e-mail plutôt que l’autre, même si les taux de clics ne se sont pas révélés statistiquement significatifs. L’équipe peut également comparer les taux d’ouverture à l’aide d’une méthode similaire pour obtenir un autre élément de comparaison.

Vous souhaitez en savoir plus sur les tests A/B d’e-mail, ou sur les tests A/B/C d’e-mail ? Lisez notre blog !